1. Introduction

L'INVENTION DES CONNAISSANCES PAR LES INFORMATICIENS

Déconstruction

des Connaissances et proposition de dépassement par la

notion de Collection

Francis

ROUSSEAUX & Thomas BOUAZIZ

Université de Reims (1) ;

Association ExperiensS (2)

SOMMAIRE :

1.

Introduction

2.

L'invention des Connaissances en informatique

2.1.

La situation de l'Intelligence artificielle en 1982

2.2.

La proposition d'Allen Newell : The Knowledge Level

2.3.

Aparté épistémologique

2.4.

Placement épistémologique de l'hypothèse du

Knowledge Level

2.5.

Les conséquences du geste de Newell

2.6.

L'invention de Newell sur le terrain : retours d'expériences

3.

Naviguer au travers de documents numériques musicaux

3.1.

Présentation du système de navigation musicale LE

MUSICOLOGUE

3.2.

Le cursus comme collection de pièces travaillées

3.3.

Étude du système de navigation CUIDADO

3.4.

Conclusion partielle et premiers enseignements

4.

Naviguer au travers de documents numériques

carto/scénographiques

4.1.

Étude du système de suivi de situations critiques

CHEOPS

4.2.

Le système de génération de collections

d'interactions VIRTUALIS

4.3.

Nouvelles conclusions et enseignements supplémentaires

5.

Déconstruction des Connaissances et invention de la

Collection

ANNEXES

A.1.

Le système de navigation musicale LE MUSICOLOGUE

A.2.

Étude du système de navigation CUIDADO

A.3.

Étude du système de suivi de situations critiques

CHEOPS

A.4.

Le système de génération de collections

d'interactions VIRTUALIS

A.5.

Bilan de la revue de systèmes

Résumé : Lorsqu’en 1982 Allen Newell a inventé une nouvelle acception des connaissances pour permettre aux informaticiens d’unifier les deux inspirations fondatrices de l’intelligence artificielle, il était peut-être loin d’imaginer l’immense succès qu’allaient rencontrer ses propositions. La manière de penser les documents numériques et les outils interactifs d’accès à leurs contenus allaient s’en trouver profondément marquée, ouvrant à nombre d’applications innovantes. Pourtant, une analyse de systèmes d’aide à l’interprétation de documents réalisés depuis les quinze dernières années sur la base des propositions de Newell révèle une surprise de taille : pour concevoir une grande partie de ces systèmes, les ingénieurs se sont en réalité efforcés de déconstruire ces propositions. Typiquement, il apparaît qu’à la notion de connaissances est préférée celle de collections. Mais cette dernière ne pouvait peut-être émerger qu’en mobilisant la première pour la tordre et la détourner.

Abstract: Allen Newell wrote his paper “ The Knowledge Level ” in 1982, inventing a new meaning for knowledge, useful for computer scientists. This proposition was very innovative, allowing systems designers to think differently the notions of digital document and browsing among content. But by analysing several recent systems, we have found that most of it tries to build down that Knowledge approach and to replace it by a Collection approach.

1.

Introduction ![]()

Nous sommes marqués par une tradition qui voudrait que les documents aient un contenu de connaissances. Cette figure du contenant excède pourtant manifestement le phénomène qu'elle prétend décrire.

Pourquoi ne pas résider au plus près du phénomène éprouvé, quitte à retarder l’acceptation d’explications trop ad hoc pour rester stimulantes ? Voici ce que nous vivons en première main : lorsqu'elle réussit, la "prise de connaissance" d'un document ébranle et anime la pensée, ouvre un horizon d'investigation et d'altérité, phénomène se traduisant par le désir de sa continuation, par une persévérance dans la confrontation au document (ou par glissements, à d'autres documents), et conduisant typiquement à la production de nouveaux documents. Lorsqu'ils se laissent recevoir sous la figure de l'attraction (continuation/répétition) et non de la répulsion, les documents donnent à concevoir et à produire d'autres documents.

Aussi, le propre de la culture est de ne jamais commencer et de ne pas finir dans l'instant, la vraie question étant celle de la possibilité de sa reprise et de sa métamorphose [Merleau-Ponty, B13 page 113]. Si ce que je dis n'est déjà plus ce que je pense du fait même que je le dise, comment la pensée pourrait-elle consister en une manipulation de connaissances déjà là, ou en un simple ré-agencement d'unités élémentaires stockées dans des réservoirs appelés documents ?

Les informaticiens sont souvent des défenseurs ardents et innocents de cette tradition qui défend la thèse du contenu de connaissances des documents. Non pas qu'ils aient été recrutés par quelque promoteur militant de cette thèse, ni même qu'ils soient particulièrement intéressés au débat. Mais l'histoire de l'informatique, qui s'origine avec celle de l'Intelligence artificielle (IA), les conduit naturellement à prendre position implicite sur un terrain somme toute stratégique : en effet, à l'heure du document numérique, ce sont bien souvent les informaticiens qui sont amenés à concevoir et réaliser les systèmes d'accès et de navigation qui recouvrent désormais le monde de leurs réseaux et de leurs services [Enjalbert, A7].

Dans cet article, nous proposons d'enquêter sur l'invention des Connaissances1 en informatique, qui constitue selon nous l'origine du regard sous influence que portent beaucoup d’informaticiens sur la question du numérique.

2.

L'invention des Connaissances en informatique

![]()

Si l'informatique est une discipline jeune, elle n'en a pas moins une histoire riche et tourmentée [Rousseaux, C10 et C16], qui commence avec la Guerre froide sous la forme d'un vaste et ambitieux projet transdisciplinaire dont le nom seul dit assez les finalités, si tant est qu'on se souvienne du sens de renseignement que revêt intelligenceen anglais : Artificial Intelligence.

Le domaine de recherche est marqué par les propositions fondatrices d'Alan Turing, dynamisé par les prévisions dithyrambiques d'un Herbert Simon, pour ne rien dire des autres contributions déterminantes. Cela, tout le monde le sait. Mais on oublie souvent le rôle fondamental joué par Allen Newell, qui a littéralement inventé une acception nouvelle d'une notion très importante en métaphysique, en construisant les Connaissances au sens des informaticiens. Il s’agissait de bâtir une notion opérante et propice aux concepteurs et programmeurs de systèmes informatisés, tout en essayant de les convaincre qu’ils tenaient là le Graal que la métaphysique, depuis la nuit des temps, s’échinait en vain à définir. Nombreux et judicieux sont les informaticiens qui ont cherché à innover sur la base des propositions de Newell, et plus nombreux encore sont ceux qui ont subi ses idées sans même pouvoir situer leurs origines.

2.1.

La situation de l'Intelligence artificielle en 1982

![]()

Quelle était la situation de l'IA en 1982, lorsque Newell entreprit de rédiger son fameux article "The Knowledge Level" [Newell, A12] ? Pour le dire poétiquement, le programme de recherche IA était au bord de sombrer dans son gouffre originaire, qui ne cessait alors de se creuser entre les deux bords de sa circonscription utopique, ironiquement instituée par Alan Turing à travers les deux figures de sa Machine et de son Test [Turing, A21].

La Machine de Turing est une machine virtuelle logique, qui sera plus tard architecturée par von Neumann [von Neumann, A26] et bientôt réalisée matériellement dans le silicium des ordinateurs, qui permet d'opérationnaliser et de simuler certains phénomènes temporels et/ou causaux par assimilation de la raison nécessaire (Modus Ponensou principe de déduction) avec la causalité, puis effectuation automatique des inférences logiques transformées en calcul [Turing, A22]. Du côté de la Machine de Turing, l'IA consiste en un corpus de techniques de programmation spécifiées pour aborder des questions de Résolution de problèmes2, celles-là même que Newell adresse avec son General Problem Solver (GPS).

Le Test de Turing, lui, rattache au dialogue intersubjectif le mystère de sa continuation : un interlocuteur est considéré comme intelligent dès lors qu’il fait rebondir le dialogue. Tout acteur intelligent doit demeurer ainsi dans le champ du dialogue constructif et tenir son interlocuteur en haleine en proposant des tirades stimulantes. Quant à l'initiative de la rupture dialogique, chacun entend bien en disposer dans son propre intérêt et en imposer la maîtrise. C’est ainsi qu’un Humain peut en venir à personnifier un interlocuteur artificiel, dès lors que ce dernier est considéré comme intelligent, capable de prolonger l’échange dans la durée et de rester à la merci du locuteur humain3.Aussi du côté du Test de Turing, l'IA est-elle une investigation phénoménologique sur la question du sujet dialoguant.

Force est de constater que l'IA s'est développée sans parvenir jamais à combler le gouffre béant entre ces deux pôles également fondateurs. En 1982, le hiatus est critique : impossible de rapprocher les deux bords, malgré les promesses présomptueuses4 et les investissements massifs. Le projet de recherche avance pourtant sur son versant Machine, mais l'IA s’enferme dans la programmation des ordinateurs et les tentatives de satisfaire des exigences d'environnement technique et d'interfaces spécifiques, sous couvert des paradigmes dominants de la Théorie de l'information, se trouvant peu à peu réduite à une techno-science. Inversement, le projet tourne court sur son versant Test, inspiré par la philosophie analytique, et demeure à l'état d’une gnose consistant à s’interroger en boucle ouverte sur les similitudes entre une Machine intelligente et un système nerveux humain. En conséquence de cette schizophrénie, les systèmes d'IA ne sortent pas significativement des Laboratoires de recherche, et cet échec retentissant devient difficile à cacher : il fallait se résoudre à jeter l'éponge ou bien ouvrir de nouvelles voies en tentant “ le tout pour le tout ”.

Newell veut agir pour défendre les chances de l’approche IA, refusant la réduction de l'ambitieux programme de recherche de Turing à une ingénierie au service de la Théorie de l'information. De par sa culture, en tant qu'ingénieur passionné par le versant ingénierie de l'IA, c'est du côté de la Machine que Newell intervient, en proposant de considérer les ordinateurs comme des systèmes en couches (Symbol Level), auxquels il propose d'ajouter une couche supérieure (le Knowledge Level), construite pour atteindre le versant Test de l'IA et solder définitivement la crise menaçante, par liquidation pure et simple du gouffre empli de questions scarifiant la discipline.

2.2.

La proposition d'Allen Newell : The Knowledge Level

![]()

Newell invente les Connaissances pour résoudre la question problématique de l'organisation Humain-Machine en Intelligence artificielle : à la question controversée "Qui est intelligent, de l'Humain ou de la Machine ?", il répond "Rendons-les intelligents ensemble, comme couple/groupe/organisation hybride multiagent; les Connaissances seront le point d'articulation du couplage, l’interdépendance du couple".

Les Connaissances désignent ainsi en informatique la condition de possibilité de l'hypothèse du Niveau des connaissances de Newell. Une coopération interactive Humain-Machine est ouverte sur la base d’un principe de rationalité (j'aime exprimer ce principe à la manière de Montaigne : dis-moi ce que veux, ce que peux, ce que sais, je te dirai ce que fais). En tant qu'elles sont manipulables par l'Humain, qui peut désormais penser sa pensée comme outil rationnel et finalisé, les Connaissances épuisent/réduisent/décrivent le phénomène de la pensée. En tant qu'elles sont représentables et engrammables dans des systèmes informatiques, elles informent les ordinateurs des situations et des degrés de liberté des actions humaines, qui pourront mobiliser l'opération d'instanciation5 ainsi que les inférences logiques pour s’enrôler dans des raisonnements rationnels divers.

Assez curieusement, les Connaissances sont d'emblée réifiées [Perrot, A17] et catégorisées sous forme de molécules représentables par une topologie atomique granulaire : une Connaissance au singulier, à l'état isolé6, n'aurait pas de sens. La représentation est clairement calquée sur le modèle physique de la matière, avec ses atomes et ses molécules. Les Connaissances se donnent toujours sous une forme différentielle et cartographique.

Quoi qu’il en soit, grâce à Newell, l'IA quitte à la fois le champ limité de la programmation des ordinateurs et la poétique turingienne pour conquérir les organisations, considérées comme des communautés d'agents humains en interaction, dans lesquelles il s'agit désormais d'insérer avec productivité des agents artificiels rationnels. Car même si Newell s'adresse en priorité au couple Humain-Machine, ce seront bientôt des sociétés multiagent bien plus larges7 qui vont être modélisées au Knowledge Level.

Newell eut en effet le talent de concevoir le geste salvateur jusqu'au bout, en nommant le lieu du monstre dual8 qu’il venait de créer et en le baptisant de façon à l'amadouer et l'apprivoiser. Le lieu du monstre était d'ailleurs déjà pointé par Turing : l'interaction Humain-Machine, comme lieu dépassant à la fois les deux protagonistes, unifiant mystérieusement la Machine au Test. Sa condition de possibilité ? Partager les Connaissances. L'Humain permet à la Machine d'acquérir ses Connaissances, quand la Machine offre à l'Humain d'apparaître comme un interlocuteur digne de lui. À peine opérationnalisée, la notion de Connaissances est ainsi associée à la connaissance du sens commun, pour faire d'un monstre une figure reconnue et opérante (c'est la tératologie — la science des monstres, qui nous enseigne ce subterfuge).

2.3.

Aparté épistémologique

![]()

C'est souvent ainsi que procède la science : l'éther, le principe digestif, l'espace-temps de la Relativité, l'entropie, la dualité ondulatoire/corpusculaire de la lumière, la liste est longue des monstres au nom familiarisant.

Étudiant en classes préparatoires ou en Ecole d'ingénieurs il y a une vingtaine d'années, j'aimais beaucoup les démonstrations où l'on fait mine d'accepter de restreindre a priori la portée des résultats visés en échange d'une simplificatrice restriction de la généralité des données de départ. On démontre alors le résultat, mais on montre dans le même mouvement que la restriction de la généralité des données de départ n'entame en rien la généralité du résultat, qui se trouve du coup prouvé dans toute sa généralité.

J'appelais ces démonstrations d'un genre particulier les démonstrations de type échafaudage, pour repérer le geste de retrait final de conditions initiales qui n'avaient en réalité servi qu'à échafauder une preuve élégante et efficace.

Plus tard, je croyais repérer un geste scientifique encore plus audacieux, qui consiste à liquider les problèmes les plus lourds en les transformants en axiomes et donc en condition d'expression de la vérité. Avec François Pachet à l’époque, nous avions ainsi proposé de relire ainsi le geste d'Einstein élaborant la théorie de la Relativité restreinte9 : construire un nouvel espace en cachant les problèmes fondamentaux dans les axes de description de cet espace (dont on n'a jamais à parler puisqu'ils sont les conditions même de toute expression). Pour rendre compte des innovations scientifiques, je croyais davantage à ce genre de construction qu'au Paradigme de Kuhn et à son assortiment technique de réfutation/corroboration et crise/institution. Plus tard, la relecture du théorème d’Emmy Nœther10 devait me conforter dans ces intuitions.

Considérons un autre exemple, dans le domaine musical cette fois [Rousseaux & Pachet, C14; Pachet A15] : lorsque Longuet-Higgins veut donner à voir la notion d'accord harmonique et qu'il recherche le bon espace de représentation de cette notion, il s'empresse de choisir les dimensions d'espace qui conféreront de bonnes propriétés expressives à l'espace en masquant au mieux, évacuées dans les dimensions mêmes, les mauvaises propriétés de l'ensemble, c’est-à-dire celles qui desservent l’émergence visée [Longuet-Higgins, A10].

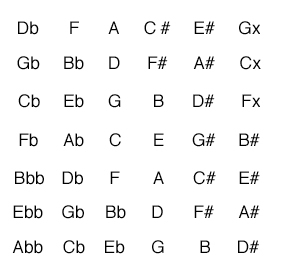

Le problème est de trouver une représentation claire des relations harmoniques entre notes, appelées accords en musique tonale. L’espace dans lequel les notes ou accords sont naturellement représentés est l’espace physique de la partition à deux dimensions (le temps en abscisse, la hauteur en ordonnée, moyennant quelques conventions d’écriture). Il se trouve que les relations harmoniques entre accords ou notes dans cet espace “naturel” (mais aussi pauvre) sont très difficiles à exhiber. Longuet-Higgins propose un espace particulier dans lequel les notes (pitch-classes) sont représentées à l'aide de deux dimensions (accessoirement, le temps disparaît). Dans cet espace particulier, l’axe d'abscisse représente des sauts de tierce mineure, et celui de l'ordonnée des sauts de quinte (il y a plusieurs variations autour de ce thème). Ce qui est remarquable c’est qu’alors les structures harmoniques classiques deviennent isomorphes à des figures géométriques. Ainsi un accord parfait majeur sera toujours représenté par un “L”, et réciproquement. On peut alors immédiatement identifier dans cet espace les structures harmoniques et les relations qu’elles entretiennent (on représente ainsi les notes, accords, gammes, etc). Ici, une manière d’interpréter ce changement d’espace est de dire qu’on a gagné en visibilité des structures harmoniques, au prix de la disparition des intervalles : ceux-ci sont fondus dans les axes, un peu comme la gravitation dans l’espace de la relativité générale.

Dans la figure de l'espace harmonique, chaque note est inscrite dans un rectangle de dimension 6*7, comme représenté ci-après :

Figure 1. Un espace harmonique de description des notes

Grâce à cette représentation en deux dimensions, les structures harmoniques deviennent évidentes. Ainsi, un accord parfait majeur est toujours représenté par un triangle, un accord parfait mineur par un même triangle inversé (le coin est en haut au lieu d’être en bas). Simon Holland a montré comment on pouvait exploiter cette représentation pour représenter des gammes, des séquences d’accords, et de manière générale en faire la base d’un système d’apprentissage de la musique.

À y regarder de près, on constate cependant que ce gain en visibilité s'accompagne de la disparition des intervalles de la théorie du domaine. Ce qui apparaît ici, c'est une certaine conception de l'espace déterminé par ses dimensions, visant l'expression saillante de formes que l’on confronte intentionnellement aux prégnances présumées d'un regard, ces saillances apparaissant devant un arrière-plan d'horizon limité par les dimensions d'espace (effet de concentration), courbées par des attracteurs masqués dans les dimensions et dont on ne peut rien dire (effet de conformation). En d'autres termes, l'enjeu d'un espace est toujours de supporter des représentations incitant à l'interprétation, candidates à être investies de sens.

2.4.

Placement épistémologique de l'hypothèse du

Knowledge Level

![]()

Il me semble que Newell a opéré un geste de même type en bâtissant son hypothèse du Knowledge Level au lieu même de la béance, au lieu défaillant et hautement problématique de l’interaction Humain-Machine. En construisant des Connaissances faisant potentiellement lien entre l'Humain et la Machine et en suggérant qu'il était raisonnable d'assimiler sans discuter ces Connaissances à la connaissance du sens commun, il réalisait un coup de maître, ouvrant un horizon d'innovation très important. La condition d'ouverture de cet horizon ? Prendre au sérieux la coïncidence entre les deux acceptions de la connaissance, faire "comme si" à tout le moins, l'investir de sens et s'appuyer sans réserve sur son évidence supposée, afin de la faire fictionner. Au passage, soulignons que rien n'exigeait une reddition sans condition à la nouvelle acception de la connaissance, rien n'exigeait qu'on opère une réduction radicale, définitive et dogmatique.

Newell proposait au fond aux chercheurs en IA et en informatique de se comporter stratégiquement comme si les Connaissances informatiques étaient mêmes que la connaissance du sens commun, et leur recommandait de jouer avec cette assimilation [Fink, B5; Bachimont, A1]. Nul n’était tenu à se rendre naïvement au nouveau dogme, corps et âme11.

2.5.

Les conséquences du geste de Newell

![]()

Les Connaissances de Newell sont logiques, plus précisément téléologiques, hors du temps et du désir humains. Ses Connaissances peuvent être régionales/domaniales, orientées métier, mais elles ne sont pas situées, elles sont littéralement inhabitées, comme le montre le type d’aporie (logique) auquel Newell admet se heurter (The Lady and the Tiger). Newell est chercheur en Résolution de problèmes, il a réalisé son GPS : pour lui, la vie est un vaste problème, et vivre est un vaste mécanisme de résolution de ce problème. Les Connaissances de Newell prétendent réduire la connaissance banale de l'imaginaire humain, narrative et discursive,déployée dans la durée, pour la recouvrir définitivement d’une chape de rationalité immédiatement finalisée.

À l'occasion, l’exigence de rationalité des Connaissances stigmatisera l'irrationnel de la connaissance narrative : quel est votre problème ? Si vous n'en avez pas, si vous ne parvenez pas à en exhiber une expression formelle canonique, alors vous n'avez pas de problème, vous allez bien … Les Connaissances — Knowledge (symbolisé par la lettre K en anglais, comme la nouvelle de Kafka), auront parfois des allures kafkaïennes.

Prise au pied de la lettre, la proposition de Newell appauvrit certes notre pensée, mais elle a aussi sa productivité et sa capacité d’innovation propres. De plus, rien n'empêche de chercher à la déconstruire, en mettant en avant des inventions moins durement réductrices comme la notion de collection [Vignaux, A24], davantage située, se déployant ici et maintenant, en singularité, dans un champ d'attraction dynamique. Le parcours peut devenir chorégraphique/scénographique, et renoncer au caractère topologique, toujours a priori cartographiable, de son inscription. Mais de cela nous parlerons plus tard.

Car la question de l'interaction collaborative est certes celle de son établissement équitable et fructueux, mais aussi celle de sa durée, c'est-à-dire de son déploiement dans le temps12.

2.6.

L'invention de Newell sur le terrain : retours d'expériences

![]()

L’analyse d’exemples de systèmes informatisés que nous connaissons bien, pour avoir participé de près ou de loin à leur conception/réalisation, nous autorise une étude critique de la productivité des Connaissances inventés par Allen Newell. On appuiera cette analyse sur les systèmes de navigation dans des recueils numériques de morceaux de musique LE MUSICOLOGUE et CUIDADO d'une part, et les systèmes de contrôle de situations CHEOPS et VIRTUALIS d'autre part.

On trouvera une description plus détaillée de ces systèmes en Annexe du présent article.

3.

Naviguer au travers de documents numériques musicaux

![]()

La mise en place d’un système de navigation au travers de documents musicaux numérisés pose toujours de difficiles problèmes préalables d’acquisition et de restitution, mais aussi de représentation et d’interface Humain-Machine. Lorsque ces problèmes sont enfin surmontés, c’est seulement alors qu’apparaît la difficulté fondamentale : mobiliser les outils basés sur le Knowledge Levelde Newell pour néanmoins subvertir ses propositions initiales, affadir l’instanciation et la classification a priori, pour aller vers la similarité en situation et la collection déployée en singularité.

3.1.

Présentation du système de navigation musicale LE

MUSICOLOGUE

![]()

Le système LE MUSICOLOGUE (cf. Annexe A.1) a été conçu et réalisé par une petite équipe d'informaticiens et de musicologues entre 1987 et 1990. Parmi les ambitions du système, on a voulu permettre à un élève venant de s'exercer à la dictée musicale sur une certaine pièce de s'en voir proposer d'autres par le système [Rousseaux & Saoudi, C15], selon une cohérence optimale du cursus, dans le sens d’une collection d’exercices travaillés adaptés la progression de l’élève. LE MUSICOLOGUE était pensé comme un éventail de méthodes, chacune préparée par un enseignant, construites autour d’un recueil de textes musicaux choisis et d’une sélection d’outils d’analyse de la pièce et d’évaluation de la progression de l’élève.

Le sous-système en charge de faire des propositions concrètes de pièces à travailler, fonction de la pièce couramment traitée et des difficultés singulières de l'élève, nous a amenés à mobiliser le système DISCIPLE, développé quelques années auparavant dans l'équipe de recherche en Apprentissage automatique de l'Université Paris 11, et auquel nous avions eu l'occasion de contribuer [Kodratoff, Tecuci et Rousseaux C3].

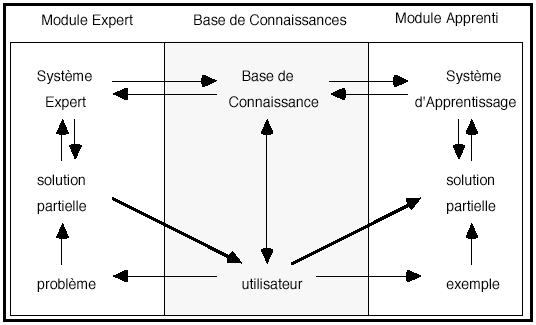

DISCIPLE est un système apprenti d'aide à la navigation dans un processus logique de résolution de problèmes par régression de but, principalement mis en œuvre dans le domaine de la planification. DISCIPLE apprend en recherchant la mise en cohérence des deux champs de Connaissances qu'il maintient : les Connaissances pratiques, qui sont des règles de décomposition de problèmes d'une part, et les Connaissances théoriques du domaine d'autre part, qui sont représentées dans un vaste Réseau sémantique [Brachman, A2] (on ne parlait pas encore d'ontologie) qui met en réseau les objets impliqués dans les règles.

DISCIPLE était développé dans une logique de formalisme théorique d'apprentissage, faisant peu de cas de l'interaction Humain-Machine, la réduisant à une forme de clientélisme typique des Systèmes experts : l'Humain attend des solutions, le système lui en propose, et c'est seulement lorsque le système informatisé s'avère incompétent qu'un expert est mandaté pour engager un processus de mise à jour et d'apprentissage des Connaissances guidé par la Machine.

3.2.

Le cursus comme collection de pièces travaillées

![]()

LE MUSICOLOGUE aide l'élève à constituer sa collection de pièces travaillées. Collectionner est plus originaire que catégoriser. C'est dans le fil du temps, du lewensvelt. C'est particulièrement vrai dans le cas d'un travail sur des pièces musicales, dont l'empreinte du succès est la continuation d'une activité qui ne cesse ni ne répète son objet, mais se prolonge sur des objets dont la succession fait parcours de collection [Rousseaux C18], un peu comme lorsqu'on constitue une collection d'œuvres d'art (même si l'appropriation des objets temporels n'est pas comparable à l'appropriation des objets spatiaux). Mais si la trace dans le monde d'une activité n'est autre que sa continuation, comment installer un dialogue Humain-Machine, et sur quel type de Connaissances médianes l'instaurer ?

Dans le cas de l'environnement d'insertion de LE MUSICOLOGUE, l'élève laisse des traces de son activité d'exercice autres que la sélection préliminaire de la pièce qui l'occupe : l'évaluation de son travail, ainsi que l’évaluation de son niveau dans le cursus, ont été soigneusement conçues pour donner prise à un système apprenti qui pourra stimuler l'intérêt de l'élève en lui proposant des pièces intéressantes à travailler, parmi lesquelles l'élève aura tout loisir de faire son choix motivé. Mais qu'en serait-il de l'activité d'écoute musicale pure, sans prise de note ni autre trace que le seul désir de sa continuation ? Pourrait-on envisager un système qui se propose pour aider l'auditeur à constituer un parcours/collection, alors même qu'aucun but extérieur à l'activité en situation ne peut être assigné au système ? C'est l'objectif du Music Browser développé par Sony-CSL dans le cadre du projet européen CUIDADO, co-ordonné par l'Ircam entre les années 2000 et 2003 [Vinet, Herrera et Pachet, A25].

3.3.

Étude du système de navigation CUIDADO

![]()

La navigation musicale au sein de vastes corpus de titres numérisés est très influencée par la notion de genre, elle-même héritée de la nécessité de choisir physiquement les CDs qu'on désire se procurer parmi les bacs et les rayonnages des grands magasins spécialisés. La fin du support CD signe la fin de l’hégémonie de cette activité d’achat et laisse place à une ribambelle d’activités concurrentes et prétendant infléchir l’indexation, d’où l’avènement de régimes d’indexations pléthoriques et concurrents. C'est pourquoi le Music Browser de CUIDADO (cf. Annexe A.2) propose, concurremment à une indexation par métadonnées éditoriales, des possibilités de fouille culturelle et acoustique, renonçant d'ailleurs à imposer des catégorisations exclusives basées sur ces types d'index, mais encourageant l'utilisateur à glisser par une recherche de similarités aussi transversale13 et interactive que ses caprices le lui inspirent [Pachet A14 et A16]. C'est encore une fois l'esprit de collection qui est à l'œuvre, et le système offre au collectionneur/auditeur des opportunités qui se conjuguent sur des plans différents mais toujours simultanément activables, liberté lui étant laissée de choisir celle sur laquelle il va localement exercer son contrôle.

3.4.

Conclusion partielle et premiers enseignements

![]()

Les différences entre les systèmes LE MUSICOLOGUE et CUIDADO ne sont pas tant techniques qu’épistémologiques. D’un système à l’autre, on passe (LE MUSICOLOGUE) d’un monde de catégories formelles où la Machine tend à piloter la boucle d’événements interactifs à (CUIDADO) une situation où il est question de collections singulières et où l’Humain tend à rester maître et ultime responsable de cette boucle d’événements, ainsi que des résultats auxquels le système Humain-Machine aboutit. Encore ne parle-t-on plus de résultats dans le cas de CUIDADO mais de parcours, la connaissance étant située en ce sens qu'elle est toujours engagée dans une narration qui s’entretient sans nécessité de buts exogènes ou endogènes au système, par glissements en similarité.

4.

Naviguer au travers de documents numériques

carto/scénographiques

![]()

Dans cette deuxième phase d’analyse de systèmes, on s’intéresse à des réalisations qui traitent cette fois de documents de nature cartographique ou scénographique. Exactement dans le même mouvement qui va du système LE MUSICOLOGUE (1990) à CUIDADO (2000) en affranchissant la conception du système informatisé d’exigences téléologiques explicites ou implicites, nous présentons les systèmes CHEOPS (1995) et VIRTUALIS (2005) en mettant en évidence un mouvement de même nature.

4.1.

Étude du système de suivi de situations critiques

CHEOPS

![]()

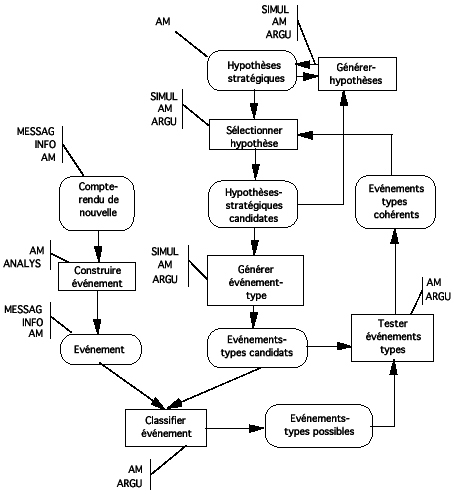

CHEOPS [Rousseaux, C8] est un système d'aide à la décision en situations de crise géopolitique, conçu et réalisé entre 1990 et 1995, et intégrant des composants informatiques pour réaliser la possibilité de débats contradictoires de niveau stratégique entre un Humain et un agent artificiel argumenteur [Rosenthal-Sabroux et Rousseaux,C4; Zacklad et Rousseaux, C17]. Cet agent tente toujours de présenter d’autres facettes de la situation tactico-stratégique au décideur, pour éviter à ce dernier d’oublier des contradictions fructueuses possibles (et surtout celles qui pourraient faire triompher un éventuel contradicteur ou adversaire).

Dans CHEOPS (cf. Annexe A.3), les documents numériques fondamentaux étaient des cartes géographiques (raster et/ou vecteur) augmentées de symboles décrivant une situation courante, et dont on supposait l'interprétation quasi-objective au niveau tactique, pour rechercher des interprétations raisonnables/justifiables au niveau stratégique (le rapport tactique/stratégique ressemble au rapport local/global de nos descripteurs solfégiques de la musique).

Mais CHEOPS permet aussi bien de légitimer les décisions que de les former, les intentions stratégiques du décideur infléchissant l’interprétation de la situation en concurrence avec les analyses tactiques qui en émergent. Quant aux explications qui sont supposées remonter du terrain jusqu’aux États-majors, elles sont concurrencées par des justifications d’action intentionnelles qui prescrivent l’interprétation du terrain.

Avec CHEOPS, il devient clair que le statut des Connaissances introduites par les informaticiens dans le paysage Humain-Machine peut avoir des conséquences sur les organisations, voire même des effets directs sur leur institution. D'abord "à extraire" en amont du cycle de conception des systèmes intelligents, les Connaissances sont vite devenues l'enjeu de l'Acquisition des Connaissances comme "principe constructif de modélisation" [Clancey A5]. Mais finalement, ce principe modéré est vite devenu principe de management et d'organisation (par exemple en vue d'unifications normatives des vues au sein d'une même organisation), et donc principe d’institution organique. C'est ainsi que l'innovation de Newell tend à ébranler le champ d'insertion des outils qu'elle conduit à produire, c’est-à-dire l'organisation elle-même, sommée de laisser place à des agents rationnels artificiels, et finalement elle-même finalisée et normalisée en conséquence.

Au fond, CHEOPS n’est pertinent que si l’on considère qu’il est possible de mettre à distance une situation pour procéder à des décisions, vues comme des réorganisations partielles de certaines composantes de cette situation. La situation serait en quelque sorte congelée avant cette opération, et ne serait pas affectée par la visée délibératrice. Or une grande partie de notre investigation philosophique, alors que nous animions entre 1997 et 2000 le groupe de recherche “ Reconstitution de la décision politico-stratégique ” du Collège international de philosophie, a consisté à montrer les considérables limites de cette vision (voir notamment, à l’adresse http://recherche.ircam.fr/equipes/sel/rousseaux/essais.htm le texte L’effondrement de la nef de Beauvais).

C’est suite à cette enquête philosophique que l’idée du système d’aide à la scénographie VIRTUALIS est née, comme dispositif Humain-Machine destiné à explorer d’autres postures de décision.

4.2.

Le système de génération de collections

d'interactions VIRTUALIS

![]()

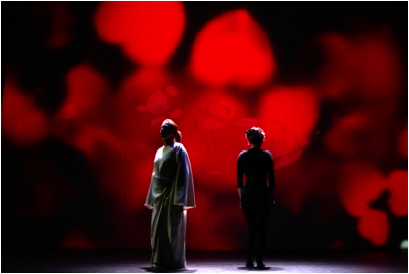

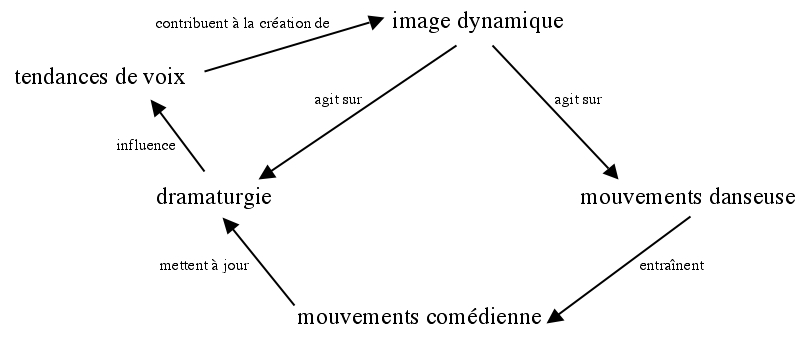

VIRTUALIS (cf. Annexe A.4) est un système établi sur l'idée qu'un spectacle vivant peut être considéré comme une collection/procession d'interactions sous contrainte, et que la mise en œuvre de procédés de rétention de certains échanges interactifs peut ouvrir l'œuvre (au sens de l'œuvre ouverte d'Umberto Eco), en permettant de densifier l'espace des interactions [Rousseaux et Bonardi, C5].

Par exemple, Alain Bonardi, principal concepteur de VIRTUALIS [Bonardi et Rousseaux, C1; C2], a mis en œuvre le système dans la création d'une pièce de Geneviève de Gaulle mettant en scène une narratrice et une danseuse Nô, mais aussi un immense écran de fond de scène sur lequel étaient dessinés des mobiles qui s'animaient en lien avec les émotions particulières de la voix de la narratrice. Ainsi, l'influence immédiate de la voix se trouvait concurremment médiatisée par l'écran et acquérait ainsi une portée et une rémanence supplémentaires dans l'ordre de l'épaisseur temporelle.

Figure

2. Une scène de La

traversée de la nuit

Ce qui nous intéressait dans ce travail était de parvenir à affadir l'instanciation14 [Rousseaux et Bonardi, C6], le fameux impensé de l'informatique, en proposant qu'une mise en scène ne soit plus contrôlée et spécifiée par des variations d'instanciation dans des ontologies de personnages et d'actions, mais davantage par un glissement de situation contrôlé par la situation elle-même.

Par une approche Fouille de données interactive, on représente l'exemple comme une spécialisation de l'ensemble des cas, et on cherche d'autres spécialisations voisines, mais sans disposer par avance d'une ontologie. L'utilisateur accepte de la façonner à sa main avec l'aide interactive de la machine, de manière ad hoc.

Le système des interactions multimodales dans La traversée de la nuit repose sur un système homme-machine “ autarcique ” : une comédienne, Valérie Le Louédec, disant l'intégralité du texte, une danseuse, Magali Bruneau, accomplissant un certain nombre de gestes inspirés du théâtre Nô et un ordinateur multimédia, acteur artificiel. L’ordinateur se manifeste sous forme d’images projetées sur un écran de fond de scène de très vastes dimensions (la comédienne et la danseuse en voient toujours au moins une partie sans se retourner), provoquant la réaction des deux comédiennes, notamment de la danseuse adaptant la réalisation de sa gestuelle aux mouvements et qualités de l’image. Or, les deux actrices sur scène constituent les deux versants — conscient et inconscient — du même personnage, selon les traditions du shite et du waki du théâtre Nô. Entraînée dans ses déplacements par la danseuse, la comédienne adapte elle aussi sa déclamation, sans compter les moments où elle regarde aussi l’écran. Pour boucler la boucle, l’ordinateur capte les états émotionnels de la voix de la comédienne.

4.3.

Nouvelles conclusions et enseignements supplémentaires

![]()

Avec VIRTUALIS, Alain Bonardi et moi découvrions que la technologie permet de se passer des concepts mêmes qui lui ont permis d'exister, ou plus exactement de les déconstruire, au sens de Derrida. Ainsi, après même qu’elles aient subrepticement prescrit des organisations dans leurs méthodes de travail et de conception, les Connaissances moléculaires et cartographiées de Newell pouvaient être déconstruites. La notion laisse place à autant de scénographies/chorégraphies qu'il y a d'expériences à l'œuvre, dans un mouvement qui rappelle celui de la concrétisation au sens de Simondon [Simondon B16], l'innovation consistant à déconstruire ces Connaissances pour en liquider l'artifice, tout en continuant à mobiliser les outils que la notion dogmatique a permis de constituer.

Après l'Information et le Rapport fonds/forme, c'est au tour des notions de Connaissances et de Contenu des documents numériques d'être mises en tension.

5.

Déconstruction des Connaissances et invention de la

Collection ![]()

En revisitant ces expériences de conception de systèmes intelligents d’aide à l’interprétation de documents numériques, nous avons constaté que la proposition d'une description a priori de la connaissance, hors situation vécue, nous a souvent laissé insatisfaits, et que nous lui avons préféré celle de glissement des situations, fondant une interaction Humain-Machine dans la durée, au travers de formes narratives, et permettant la constitution de collections inspirées, à l'intentionnalité mouvante et vivante.

Les documents numériques, n’en déplaise aux informaticiens, ne contiennent pas de connaissances. Leur “ prise de connaissance ” est bien plutôt un processus élaboratif de collection, qui vise concurremment sa terminaison et sa continuation, les deux visées étant nécessaires ensemble parce qu’elles entretiennent leurs possibilités réciproques.

ANNEXES

: Revue des systèmes LE MUSICOLOGUE, CUIDADO, CHEOPS et

VIRTUALIS

![]()

A.1.

Le système de navigation musicale LE MUSICOLOGUE

![]()

Le système LE MUSICOLOGUE a été conçu et réalisé par une petite équipe d'informaticiens et de musicologues entre 1987 et 1990. Parmi les ambitions du système, nous nous intéressons ici à la fonctionnalité qui permet à un élève venant de s'exercer à la dictée musicale sur une certaine pièce de s'en voir proposer d'autres par le système [Rousseaux & Saoudi, C15].

Il s'agit d'aider l'élève à évoluer dans un vaste corpus numérique pour constituer une collection d'exercices travaillés qu'on appelle ordinairement son cursus. Il est implicite que le cursus doit être le plus cohérent possible, dans le sens de la progression de l'élève. Mais il faut reconnaître qu’une telle vision est plus rétrospective que prospective : en réalité pour qu'un cursus soit cohérent, il faut avant tout qu'il ne cesse pas de se développer, c'est-à-dire que l'élève ne s'ennuie ni ne se décourage. Et c'est seulement en regardant en arrière qu'on pourra parler de progression de l'élève, sous condition qu’il persévère.

On imagine facilement l'environnement que LE MUSICOLOGUE doit préalablement réaliser pour rendre possible l'expression, en situation d'exercice, d'un appel d'offres de pièces à travailler encore. LE MUSICOLOGUE était pensé comme un éventail de méthodes, chacune préparée par un enseignant.

Chaque méthode était composée pour l'essentiel [Rousseaux, C12] :

- D'un recueil de textes musicaux choisis15, proposant plusieurs jeux de description des pièces (métadonnées) sur la base desquels il est notamment possible de naviguer — 1° éditorial, 2° solfégique et 3° pédagogique —, et qui donnait également accès aux formes sonore (gestuelle en réalité, le système ne prenant jamais en charge le timbre des notes mais seulement leur description "gestuelle" au format spécialisé MIDI) et graphique (la partition) des pièces;

- D'outils permettant de saisir les pièces à partir de leur forme gestuelle et/ou de leur forme graphique (mobilisés par l'enseignant mais aussi par l'élève s'exerçant à noter sous forme graphique une forme sonore entendue selon un protocole contraint, soit l'exercice de la dictée musicale), ainsi que d'outils permettant de paramétrer et contrôler les séquences d'écoute;

- D’une grille d'évaluation des exercices conformément à la vision pédagogique propre à la méthode, et préparée par l'enseignant.

Il est intéressant de préciser la structure de la grille d'évaluation, dont la conception exige de ramasser toutes les difficultés théoriques pour les lier en forme de solution heuristique. À elle seule, la conception de la grille s’apparente d’une certaine façon à la classe de ces gestes scientifiques bâtisseurs de monstres plus ou moins productifs.

A.1.1.

Les Connaissances dans LE MUSICOLOGUE

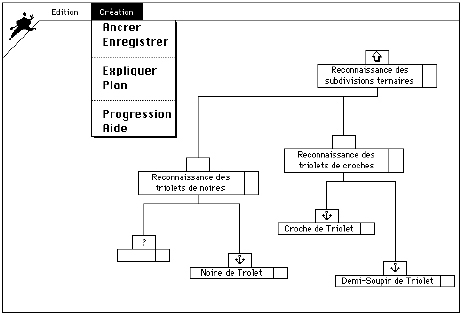

![]()

En termes contemporains, cette grille représente l'Ontologie de la méthode, car elle représente les Connaissances qui vont permettre le dialogue coopératif Humain-Machine dans les conditions définies par Newell. Formellement, il est exigé que la grille soit un arbre n-aire étiqueté (de profondeur quelconque), de façon qu'elle possède les propriétés fondamentales requises, que nous exposerons plus tard.

Il est nécessaire que la grille :

Permette à l'élève de "prendre connaissance" du bilan de son travail de transcription de la dictée, en partant typiquement du nœud racine de la grille (qui porte trace matérielle du résultat synthétique de la comparaison entre la pièce source et son imitation par l'élève), et jusqu'à analyser les difficultés rencontrées en naviguant vers les feuilles de l'arbre;

Figure 3. La grille des connaissances pédagogiques dans LE MUSICOLOGUE

Reflète aussi astucieusement que possible la manière dont l'enseignant s'acquitte d'une tâche impossible et néanmoins requise : décrire de façon hiérarchique, au moyen d'un arbre n-aire des notions solfégiques abstraites — les étiquettes des nœuds de l'arbre (à l'exception des feuilles), que l'enseignant peut libeller à sa guise —, à partir d'un vaste réservoir de notions solfégiques de base qui, elles, sont fournies par le système — les feuilles de l'arbre;

Permette le calcul automatique ascendant de la valorisation de tous les nœuds de la grille lors de la demande d'évaluation de son travail par l'élève;

Permette au système d'aide à la constitution de cursus (qui offre les pièces susceptibles d'être choisies pour le prochain exercice) de s'appuyer sur les résultats de l'élève confronté à la pièce courante, et également de garder trace de ces résultats pour le cas où un processus d'apprentissage de nouvelles règles de progression doive être engagé.

On sent bien que les exigences 1°, 3° et 4° doivent être offertes par l'exigence 2°, qui est précisément élaborée pour permettre la satisfaction de l'ensemble des fonctionnalités de la grille, en même temps qu'elle est proposée à l'enseignant comme un outil fertile pour promouvoir sa vision pédagogique16. Mais la satisfaction de l'exigence 2° n'est approchable qu'à condition d'user d'heuristiques très audacieuses. Dans le cas d'espèce en tout cas, voici le schéma d'heuristiques sur lequel nous avons misé :

Le niveau d'abstraction des notions solfégiques mobilisées pour étiqueter la grille est covariant avec leur niveau de granularité temporelle, les notions les moins abstraites étant les plus locales dans le temps (par exemple un intervalle de hauteur), les plus abstraites tendant à se présenter comme globales à la pièce (par exemple un genre musical);

Les notions solfégiques de base proposées en réservoir du système, par constructions locales et situées dans le temps, peuvent être valorisées pour chaque pièce selon des calculs d'extraction et des comptages d'occurrences;

Par simple comparaison arithmétique, il sera possible de comparer les valeurs des notions solfégiques de base entre deux pièces (par exemple un texte à travailler et son imitation produite par un élève) et d'informer les feuilles de la grille d'évaluation des difficultés de réalisation dont elles ont été l'objet (aucune localisation n'étant prise en compte, il s'agit bien d'une heuristique audacieuse, mais elle a fait preuve de son efficacité);

Par simple propagation ascendante de la valeur logique des nœuds des feuilles (la logique de propagation des nœuds intermédiaires est éditable par l'enseignant), il est possible d'évaluer chacun des nœuds de l'arbre et ce jusqu'à ce que la racine elle-même soit évaluée.

Nous disposons ainsi d'un système capable de diagnostiquer les difficultés de l'élève en termes d'une théorie solfégique exprimée par l'enseignant, ainsi que de fournir des explications de ces difficultés par navigation dans la grille, depuis la racine (qui synthétise le résultat) jusqu'aux feuilles (qui en localisent les ultimes éléments d'analyse).

A.1.2.

L'apprentissage de la Machine dans LE MUSICOLOGUE

![]()

Restait à imaginer et concevoir un sous-système capable de faire des propositions concrètes de pièces à travailler, fonction de la pièce couramment traitée et des difficultés singulières de l'élève. Pour ce faire, nous avons mobilisé le système DISCIPLE, développé quelques années auparavant dans l'équipe de recherche en Apprentissage automatique de l'Université Paris 11, et auquel nous avions eu l'occasion de contribuer [Kodratoff, Tecuci et Rousseaux C3].

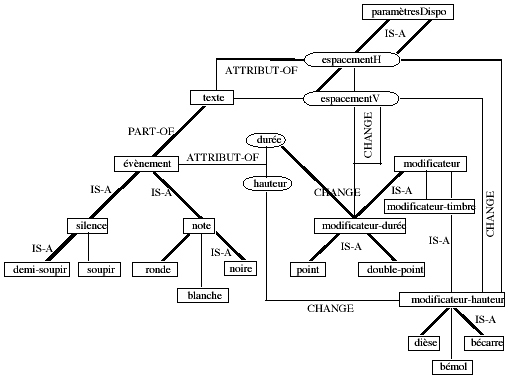

Figure 4. Les connaissances théoriques du système

DISCIPLE est un système apprenti d'aide à la navigation dans un processus logique de résolution de problèmes par régression de but, principalement mis en œuvre dans le domaine de la planification. DISCIPLE apprend en recherchant la mise en cohérence des deux champs de Connaissances qu'il maintient : les Connaissances pratiques, qui sont des règles de décomposition de problèmes d'une part, et les Connaissances théoriques du domaine d'autre part, qui sont représentées dans un vaste Réseau sémantique [Brachman, A2] (on ne parlait pas encore d'ontologie) qui met en réseau les objets impliqués dans les règles.

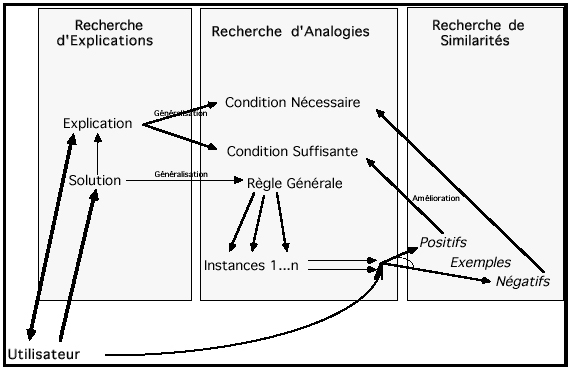

DISCIPLE vient au secours d'un Système expert en charge de décliner un problème donné par régressions successives jusqu'à des actions élémentaires identifiées et bien maîtrisées, lorsque celui-ci vient à manquer de propositions pertinentes et adéquates à la situation. DISCIPLE prend alors en charge un processus interactif d'apprentissage de nouvelles Connaissances à partir d'un exemple de solution communiqué par un expert du domaine dépêché pour la circonstance, à qui DISCIPLE demandera des explications de la pertinence de la solution en termes de la théorie du domaine avant de généraliser cette solution pour finalement en contrôler dynamiquement le niveau de généralité en fonction du niveau de robustesse avéré de la règle en cours de ses mises à l'épreuve ultérieures.

Figure 5 Le cycle d’apprentissage Machine de DISCIPLE

DISCIPLE était développé dans une logique de formalisme théorique d'apprentissage, faisant peu de cas de l'interaction Humain-Machine, la réduisant à une forme de clientélisme typique des Systèmes experts : l'Humain attend des solutions, le système lui en propose, et c'est seulement lorsque le système informatisé s'avère incompétent qu'un expert est mandaté pour engager un processus de mise à jour et d'apprentissage des Connaissances guidé par la Machine.

Figure 6. Les différentes modalités d’apprentissage combinées

Lors de l'engagement de DISCIPLE dans LE MUSICOLOGUE, on s'est efforcé de situer le dispositif d'apprentissage au cœur même du fonctionnement nominal du système, le désir de l'utilisateur/élève faisant office de savoir d'expert, la progression de l'élève étant vue comme la constitution d'une collection plus que comme un cheminement différentiel formellement cohérent. Cependant, c’est l’enseignant qui initialise la procédure d’apprentissage de la Machine en proposant des exemples de progression pédagogique situés, et en répondant à l’enquête de justification que conduira aussitôt le sous-système apprenti.

A.2.

Étude du système de navigation CUIDADO

![]()

La navigation musicale au sein de vastes corpus de titres numérisés est très influencée par la notion de genre, elle-même héritée de la nécessité de choisir physiquement les CDs qu'on désire se procurer parmi les bacs et les rayonnages des grands magasins spécialisés. Si les métadonnées éditoriales qui permettent d'indexer et de fouiller la musique numérisée sont efficaces, c'est parce qu'elles sont entretenues comme autant de passages obligés, typiquement mises en œuvre avant même l'écoute, dès la phase d'acquisition matérielle du support CD [Rousseaux, C7 et C9].

Ainsi la possibilité théorique de fouiller des titres numérisés sans passer par l'acquisition de CDs rangés dans des rayons rend bientôt obsolète l'actualité des métadonnées éditoriales, et conduit bien vite à leur péremption, à tout le moins comme modèle hégémonique d'indexation.

C'est pourquoi le Music Browser de CUIDADO propose, concurremment à une indexation par métadonnées éditoriales, des possibilités de fouille culturelle et acoustique, renonçant d'ailleurs à imposer des catégorisations exclusives basées sur ces types d'index, mais encourageant l'utilisateur à glisser par une recherche de similarités aussi transversale17 et interactive que ses caprices le lui inspirent [Pachet A14 et A16]. C'est encore une fois l'esprit de collection qui est à l'œuvre, et le système offre au collectionneur/auditeur des opportunités qui se conjuguent sur des plans différents mais toujours simultanément activables, liberté lui étant laissée de choisir celle sur laquelle il va localement exercer son contrôle.

Reprenons la démarche de façon resserrée :

1° La mise en marché des CDs via des rayonnages de magasins requiert une efficace mise en rayons a priori des produits et un système d’étiquetage par des métadonnées visibles/lisibles, déterminant du même coup une organisation qui prescrit nos descriptions de la musique et donc finalement notre culture et nos activités musicales (incluant en dernier ressort l’écoute).

2° La fin du support CD signe la fin de l’hégémonie de l’activité d’achat et laisse place à une ribambelle d’activités concurrentes et prétendant infléchir l’indexation, d’où l’avénement de régimes d’indexations pléthoriques et concurrents.

3° Un constat s’impose : il est impossible de répertorier à l’avance (et clore) ces régimes d’indexation mais à l’inverse impossible de ne pas opter pour des index prédéterminés si l’on veut (semi-)automatiser la fouille de données désormais numériques à l’aide de machines. Il est donc vain de chercher à établir des ontologies qui feraient consensus pour relier des termes d’index abstraits (les descriptions “ de haut niveau ”) à des descriptions calculées (les descriptions de “ bas niveau ”) par instanciations de simples variables d’instances (les approches type “ MPEG ”).

4° L’idée est de proposer des similarités(par l’exemple et l’analogie) surdes champs ouverts decontenus/activités ad hoc et situés, comme cela est esquissé dans le système. Mais cette piste débouche sur une contradiction dans les termes similarité et champ ouvert de contenus/activités, en tout cas dans l’horizon de la computationalité.

5° L’idée devient alors de fournir des moyens frustes pour inaugurer des similarités exploratoires (par exemple des classements heuristiques sur des éléments culturels, éditoriaux, acoustiques) et de proposer à l’utilisateur d’en faire un usage dynamique, interactif et rectificatif. Il s’agit demobiliser des instanciations, qui ont une forte charge d’appariement entre un singulier et un particulier (concept), pour les affadir et les utiliser comme provocations glissantes et négociables par révisions successives, réglables progressivement.

6° Pratiquement, l’utilisateur se lance en provoquant le monde des possibles par une première tentative d’extraction partielle et locale avant d’opérer des sélections/appréciations, destructions/adjonctions et/ou classements sur le résultat, avant d’envisager une nouvelle contrainte partielle et locale sur le reliquat. Du fait de la mixité des opérations du côté de l’utilisateur, le processus n’est pas linéaire, au sens où récapituler une requête globale de l’utilisateur sous l’égide de la logique n’aurait pas de pertinence.

7° Avec la complicité du calcul, l’utilisateur opère par provocations successives (davantage que par spécifications) : similarités constatées ou proposées, approximations successives, différenciations répétitives de proche en proche (davantage que par sélections).

8° Ce dialogue avec le calcul livre ultimement à l’utilisateur une solution acceptable, mais elle l’aide aussi à élaborer ses concepts. Bizarrement, les concepts en question ne sont pas présents a priori dansle système, il n’y a pas de hiérarchies de concepts (ontologies organisées par généralisation/spécialisation). L’utilisateur récapitule sans cesse sa démarche interactive d’accès aux contenus fréquentés par des concepts qu’il pourrait préciser par spécialisation/généralisation. Mais les instanciations qu’il fait opérer par le système sont tellement locales et affadies par les interactions que l’utilisateur peut se les représenter comme des spécialisations floues (de concepts) qui restent toujours et encore à préciser par interaction/rectification et/ou adjonction/soustractions et/ou substitutions.

9°

Voici encore d’importantes caractéristiques de l’approche

fouille de données interactive:

On

mobilise par facettes l’approche formelle, mais typiquement comme

moyen provisoire;

La

quantité joue un rôle qualitatif (jamais séparée

du qualitatif);

La

structure de liste (ordonnée) est plus usitée que celle

d’ensemble.

Les

concepts sont définis en extension, et l’exigence de

leur récapitulation en intension est abandonnée

(ce par quoi l’IA diffère des

mathématiques)— si la récapitulation à

visée conceptualisante d’une extension est effectuée,

elle ne le sera jamais par compilation d’explications logiques.

A.3.

Étude du système de suivi de situations critiques

CHEOPS

![]()

CHEOPS [Rousseaux, C8] est un système d'aide à la décision en situations de crise géopolitique, conçu et réalisé entre 1990 et 1995, et intégrant des composants informatiques pour réaliser la possibilité de débats contradictoires de niveau stratégique entre un Humain et un agent artificiel argumenteur [Rosenthal-Sabroux et Rousseaux,C4; Zacklad et Rousseaux, C17].

Le parti pris gnoséologique est d’emblée celui du Principe de raison [Heidegger B9], qui exclut toute autre approche de la décision. Cela signifie que seule une ligne du tableau suivant (non exhaustif) est retenue comme opératoire, toutes les autres étant relayées au statut de pratiques magiques ou d’élucubrations séduisantes.

|

Décider, c’est s’en remettre … |

exemple |

|

à des principes (“ tout est possible, mais tout n’édifie pas ”, principe de précaution, la Loi) |

l’édification de Paul de Tarse, la précaution de Hans Jonas, l’Ancien testament |

|

à l’art |

les artistes |

|

à la force |

la guerre |

|

à la logique, au plan |

les encyclopédistes des Lumières, Thomas d’Aquin à la suite d’Averroès, les philosophes du cercle de Vienne, les bâtisseurs de la Nef de Beauvais |

|

à la nature (humaine, astrologique) |

les stoïciens, les panthéistes |

|

à la raison “ rationnelle ” |

Newell et ses Connaissances, les Arbres de décision |

|

à la situation singulière |

Le “ discernement des esprits ” d’Ignace de Loyola, la métapolitique d’Alain Badiou |

|

à son instinct |

les darwinistes |

|

à son intelligence épique |

Don Quichotte de la Mancha |

|

à l’amour |

Héloïse, Juliette, Manon |

|

au hasard ou au jeu (cosmique) |

Eugène Fink |

|

aux autres (leur représentant, le plus grand nombre, le meilleur) |

la question politique de l’autorité |

|

aux dieux, dont il faut interpréter les messagers ou les signes (oracles, marc de café ou entrailles d’animaux) |

les Ioniens anciens décrits par Feyerabend |

Figure 7. Exemples de paradigmes possibles pour la décision

Dans CHEOPS, les documents numériques fondamentaux étaient des cartes géographiques (raster et/ou vecteur) augmentées de symboles décrivant une situation courante, et dont on supposait l'interprétation quasi-objective au niveau tactique, pour rechercher des interprétations raisonnables/justifiables au niveau stratégique (le rapport tactique/stratégique ressemble au rapport local/global de nos descripteurs solfégiques de la musique).

Figure 8. L’Induction de structure selon Simon et Léa

L'usage de CHEOPS était d’adresser le besoin présumé de décider des actions/choix stratégiques en établissant des chaînes d’explications issues du terrain tactique numérisé. À cette fin, le concepteur a réutilisé des Structures d’inférences de type KADS [Wielinga, Schreiber et Breuker, A28], comme celle qui prétend mettre à disposition, sur étagère, l’essence de l’Induction de structures, et qui fût établie en 1975 par Simon et Léa (schéma précédent).

L’idée est de permettre que l’Humain utilisateur soit mis en contradiction permanente avec un agent artificiel Argumenteur, qui tente toujours de présenter d’autres facettes de la situation tactico-stratégique au décideur, pour éviter à ce dernier d’oublier des contradictions fructueuses possibles (et surtout celles qui pourraient faire triompher un éventuel contradicteur ou adversaire).

|

|

Interprétation selon le point de vue du processus de résolution de problème | |

|

1 |

AM : Avez-vous reçu le descriptif relatif aux événements de N'Djamena ? Il semble que ce soient des manifestations organisées par des étudiants proches de l'opposition. Ceci confirme que les événements de Biltine ne sont probablement que la conséquence de problèmes liés à la solde des militaires et que nous sommes donc bien en présence d'affaires intérieures … |

construire-événement classifier-événement tester-événement-type sélectionner-hypothèse |

|

2 |

ARGU : Je ne suis pas d'accord. La cause précise des événements de Biltine n'est pas connue et l'ethnie M'Boutoul (impliqué dans les troubles de Biltine) est aussi la plus proche des rebelles. |

classifier-événement

|

|

3 |

AM : Pouvez-vous montrer qu'il est possible que les rebelles sont impliqués dans les événements récents ? |

tester-événement-type |

|

4 |

ARGU : Oui, je peux le montrer (la démonstration suit) |

classifier-événement tester-événement-type |

|

5 |

AM : Quelles en sont selon vous les conséquences ? |

générer-hypothèses-stratégiques |

|

6 |

ARGU à SIMUL (sans que la communication soit visible pour AM) : Pourriez vous me faire une estimation des rapports de force en zone sud en tenant compte des derniers événements ? |

générer-hypothèses-stratégiques

|

|

7 |

SIMUL à ARGU (sans que la communication soit visible pour AM) : En intégrant les forces rebelles et les régiments Libyens, le rapport de force est défavorable aux Tchadiens. |

générer-hypothèses-stratégiques

|

|

8 |

ARGU à AM : Si les rebelles et les Libyens sont impliqués, cela signifie qu'une attaque en zone Nord est peut-être imminente, alors que le potentiel de défense Tchadien est affaibli dans cette zone. |

générer-hypothèses-stratégiques

|

|

12 |

Intervention de MESSAG : Je viens d'avoir l'information que nous attendions : il est possible que les avions qui ont largué des bombes sur l'aéroport de N'Djamena soient de type Marchetti SF 260. |

construire-événement |

|

13 |

AM à ARGU : Il se pourrait que vous ayez raison. |

sélectionner-hypothèse-stratégique-candidate |

|

14 |

ARGU : Pourquoi ce changement d'opinion ? |

sélectionner-hypothèse-stratégique-candidate |

|

15 |

AM : Parce qu'il se peut que le bombardement ait été le fait des Libyens, qui possèdent ce genre d'avion italien, ce qui peut signifier qu'une attaque de grande envergure est peut-être en train de se préparer. |

construire-événement classifier-événement tester-événement sélectionner-hypothèse-stratégique-candidate |

Figure 9. Un exemple de dialogue entre un décideur et l’argumenteur artificiel

Mais CHEOPS permet aussi bien de légitimer les décisions que de les former, les intentions stratégiques du décideur infléchissant l’interprétation de la situation en concurrence avec les analyses tactiques qui en émergent. Quant aux explications qui sont supposées remonter du terrain jusqu’aux États-majors, elles sont concurrencées par des justifications d’action intentionnelles qui prescrivent l’interprétation du terrain.

Avec CHEOPS, il devient clair que le statut des Connaissances introduites par les informaticiens dans le paysage Humain-Machine peut avoir des conséquences sur les organisations, voire même des effets directs sur leur institution. D'abord "à extraire" en amont du cycle de conception des systèmes intelligents, les Connaissances sont vite devenues l'enjeu de l'Acquisition des Connaissances comme "principe constructif de modélisation" [Clancey A5]. Mais finalement, ce principe modéré est vite devenu principe de management et d'organisation (par exemple en vue d'unifications normatives des vues au sein d'une même organisation), et donc principe d’institution organique. C'est ainsi que l'innovation de Newell tend à ébranler le champ d'insertion des outils qu'elle conduit à produire, c’est-à-dire l'organisation elle-même, sommée de laisser place à des agents rationnels artificiels, et finalement elle-même finalisée et normalisée en conséquence.

Au fond, CHEOPS n’est pertinent que si l’on considère qu’il est possible de mettre à distance une situation pour procéder à des décisions, vues comme des réorganisations partielles de certaines composantes de cette situation. La situation serait en quelque sorte congelée avant cette opération, et ne serait pas affectée par la visée délibératrice. Or une grande partie de notre investigation philosophique, alors que nous animions entre 1997 et 2000 le groupe de recherche “ Reconstitution de la décision politico-stratégique ” du Collège international de philosophie, a consisté à montrer les considérables limites de cette vision (voir notamment, à l’adresse http://recherche.ircam.fr/equipes/sel/rousseaux/essais.htm le texte L’effondrement de la nef de Beauvais).

C’est suite à cette enquête philosophique que l’idée du système d’aide à la scénographie VIRTUALIS est née, comme dispositif Humain-Machine destiné à explorer d’autres postures de décision.

A.4.

Le système de génération de collections

d'interactions VIRTUALIS ![]()

VIRTUALIS [Bonardi et Rousseaux, C1; C2] est un système établi sur l'idée qu'un spectacle vivant peut être considéré comme une collection/procession d'interactions sous contrainte, et que la mise en œuvre de procédés de rétention de certains échanges interactifs peut ouvrir l'œuvre (au sens de l'œuvre ouverte d'Umberto Eco), en permettant de densifier l'espace des interactions [Rousseaux et Bonardi, C5].

Par exemple, Alain Bonardi, principal concepteur de VIRTUALIS, a mis en œuvre le système dans la création d'une pièce de Geneviève de Gaulle mettant en scène une narratrice et une danseuse Nô, mais aussi un immense écran de fond de scène sur lequel étaient dessinés des mobiles qui s'animaient en lien avec les émotions particulières de la voix de la narratrice. Ainsi, l'influence immédiate de la voix se trouvait concurremment médiatisée par l'écran et acquérait ainsi une portée et une rémanence supplémentaires dans l'ordre de l'épaisseur temporelle.

Ce qui nous intéressait dans ce travail était de parvenir à affadir l'instanciation18 [Rousseaux et Bonardi, C6], le fameux impensé de l'informatique, en proposant qu'une mise en scène ne soit plus contrôlée et spécifiée par des variations d'instanciation dans des ontologies de personnages et d'actions, mais davantage par un glissement de situation contrôlé par la situation elle-même. Comme pour CUIDADO tout à l’heure, essayons de rassembler brièvement les étapes de notre réflexion :

1° L’interprétation du metteur en scène repose classiquement sur une ontologie de la dramaturgie et des variations d’instanciation. Face à un texte de théâtre, chaque metteur en scène souhaite proposer sa lecture/interprétation, et une lecture/interprétation est toujours un effort pour créer des formes. Dans le cas du théâtre, cela commence par l'établissement d'une ontologie synthétique de la dramaturgie : on y décrit les personnages sous forme de types et d'instanciations (ce en quoi le théâtre de boulevard par exemple excelle avec son trio, mari, femme et amant !), en indiquant le nom du personnage, sa situation au début de la pièce et son costume. Le déroulement de la pièce propose des variations d'instanciation : le spectateur découvre au fil de l’action que tel ou tel personnage est différent de ce qu'il imaginait au départ. Ces variations d'instanciation peuvent même aboutir à des révisions de l'ontologie. C'est par exemple l'enjeu, autant métaphysique que théâtral, du Don Juan de Tirso de la Molina : l'ontologie du personnage peut-elle être radicalement modifiée à la fin de la pièce, qui correspond au moment de la mort du personnage ?

2° Cette conception traditionnelle du théâtre s’inscrit dans une approche formelle de la similarité reposant sur les ontologies. Dans cette approche traditionnelle du théâtre, la notion de similarité par les ontologies est centrale. Le metteur en scène règle chaque scène faisant unité en la considérant comme un exemple dans un ensemble de cas fournis par la littérature théâtrale. Expliquer un personnage à l'acteur qui le joue revient à le pointer dans l'ontologie proposée et à relier cette ontologie à celle d'autres pièces ou d'autres lectures de la même pièce par d'autres metteurs en scène, pour donner à comprendre par un exemple dit “ similaire ”. En généralisant, il s'agit d'une approche formelle, dans laquelle on représente l'exemple comme une instance d'une structure générale embrassant tous les cas, et on cherche les similarités en faisant varier l'instanciation. Cette approche présente l'avantage de fournir une explication du caractère "similaire à l'exemple" de la proposition, voire une mesure de distance: c'est par ce biais qu'un concept récapitulatif en intension peut être créé. Variante raffinée pour le cas où on disposerait de hiérarchies a priori de spécialisations/généralisation de concepts (ontologies) : on recherche les similarités à un exemple en demeurant dans l’enceinte du concept, quitte à passer au concept plus général quand la quête est infructueuse. Ceci s'applique à bien d'autres activités que le théâtre, par exemple l'organisation de la vente de CDs dans un grand magasin de disques dont nous avons parlé précédemment.

3° En informatique, il existe une autre approche de la similarité : c'est l'approche Fouille de données interactive, dans laquelle on représente l'exemple comme une spécialisation de l'ensemble des cas, et on cherche d'autres spécialisations voisines, mais sans disposer par avance d'une ontologie. L'utilisateur accepte de la façonner à sa main avec l'aide interactive de la machine, de manière ad hoc. Il s'agit d'une approche en extension : façonner une similarité revient à façonner une liste de contenus de forme similaire (des concepts – non langagiers – abordés en creux par leur capacité de détermination) par des opérations rectificatives successives mobilisant le calcul numérique et l’instanciation (du côté du système informatisé), en interaction interprétative avec des actions rectificatrices sur les contenus et leurs formes (du côté de l'utilisateur, provoqué par les propositions de la machine).

4° Que peut donner cette approche Fouille de données interactive au niveau de la mise en scène de théâtre ? Elle suppose l'introduction de l'ordinateur selon un mode de dialogue entre acteurs et machines. Une mise en scène peut-elle ne plus se conformer à une ontologie mais échapper à la spécification a priori en s'appuyant sur des interactions multimodales ? C'est le sens de la recherche menée sur le spectacle de théâtre intermédia La traversée de la nuit, sur le texte de Geneviève de Gaulle-Anthonioz, évoquant son emprisonnement au cachot du camp de Ravensbrück à la fin de la 2ème Guerre Mondiale.

Figure 10. Les interactions entres acteurs Humains et artificiels

5° Le système des interactions multimodales dans La traversée de la nuit repose sur un système homme-machine “ autarcique ” : une comédienne, Valérie Le Louédec, disant l'intégralité du texte, une danseuse, Magali Bruneau, accomplissant un certain nombre de gestes inspirés du théâtre Nô et un ordinateur multimédia, acteur artificiel. L’ordinateur se manifeste sous forme d’images projetées sur un écran de fond de scène de très vastes dimensions (la comédienne et la danseuse en voient toujours au moins une partie sans se retourner), provoquant la réaction des deux comédiennes, notamment de la danseuse adaptant la réalisation de sa gestuelle aux mouvements et qualités de l’image. Or, les deux actrices sur scène constituent les deux versants — conscient et inconscient — du même personnage, selon les traditions du shite et du waki du théâtre Nô. Entraînée dans ses déplacements par la danseuse, la comédienne adapte elle aussi sa déclamation, sans compter les moments où elle regarde aussi l’écran. Pour boucler la boucle, l’ordinateur capte les états émotionnels de la voix de la comédienne19.

6° L’écran de fond de scène donne à voir une rétention de la voix de la comédienne, qui casse le caractère linéaire et markovien des interactions, en donnant une dimension rémanente à un médium particulier, la voix, en tant qu’elle porte des émotions différentielles. Ainsi la pièce comme collection d’interactions (microforme) est enchâssée dans la pièce comme collection d’images animées (macroforme). Nous reviendrons en conclusion générale sur cet aspect.

A.5.

Bilan de la revue de systèmes

![]()

Nous avons passé en revue un certain nombre de systèmes interactifs Humains-Machines que nous connaissons bien (on note H pour Humains et M pour Machines).

|

|

collection |

Connaissances, similarités |

boucle d'événements |

but assigné au système |

|

LE MUSICOLOGUE |

cursus = pièces musicales travaillées |

1°

descriptions éditoriale, pédagogique, solfégique,

gestuelle et graphique des textes musicaux |

H

pilote l'exercice |

offre de continuation ancrée sur des traces formelles d’activité |

|

CUIDADO |

Play-list = pièces musicales écoutées |

description éditoriale et/ou culturelle et/ou acoustique des textes musicaux |

H

pilote l'écoute |

offre de continuation par provocation |

|

CHEOPS |

théâtre d'opération = situations critiques maîtrisées |

1°

description tactique des situations cartographiques |

H

pilote les propositions d'interprétation |

offre de contre-propositions basées sur une vision rationnelle de la décision |

|

VIRTUALIS |

spectacle vivant = interactions scéniques |

Le

rapport entre |

H

déploie le spectacle |

ouverture de l'œuvre |

Figure 11. Récapitulatif des systèmes analysés

En confrontant les différentes approches de la similarité que nous avons repérées, nous avons privilégié la notion de Similarité située et interactive :

Similarité formelle etmachinique (en intension) par variation d’une instanciation exemplaire (l’explication formelle du caractère exemplaire), l’exemple étant vu comme un particulier/prototype/spécimen d’un concept.

Similarité située etinteractive (en extension) par rectification/interprétation répétée de propositions heuristiques d’une similarité formelle, la forme des catégories étant affadie au profit d’agrégations pré-ordonnées de singularités, l’explication procédurale résistant à toute tentative de récapitulation pertinente par une explication formelle.

Chemin faisant, nous avons mis en avant la notion de Collection. À quoi correspond l’invention de la Collection en informatique ? A la déconstruction dela “ prise de connaissances ” par une “ mise en collection ”, par le truchement d’un parcours interactif, de similarité située en similarité située.

Ainsi il est apparu que depuis une quinzaine d’années et à notre insu, nous cherchons à subvertir les Connaissances de Newell pour parvenir à constituer des Collections.

NOTES

1. Pour bien indiquer que la notion de Connaissances des informaticiens ne coïncide pas de manière évidente avec la notion de connaissance du sens commun, bien que le vocable choisi par les premiers vise à provoquer cette coïncidence, nous emploierons un C majuscule pour distinguer l'acception intrusive du vocable. Sur son pluriel systématique, nous aurons l'occasion de nous expliquer dans la suite.

2. De manière générale, nous ferons débuter par une lettre majuscule tous les termes qui, dans cet article, font référence à des notions répertoriées de l'informatique.

3. Souvenons-nous du système ELISA [Weizenbaum A27] : le système jouait le rôle du psychanalyste, et non pas de l'analysé.

4. Les systèmes intelligents devaient remplacer l'Humain jusque dans les conduites/activités réputées intelligentes qu'il déploie, étendant la taylorisation à des sphères qui lui échappaient jusqu'alors.

5.L'instanciation est le grand impensé de l'informatique, qui assimile violemment le singulier au particulier [Rousseaux, C18] par le truchement de la fameuse subsomption, alors même qu'Aristote [Aristote, B1] affirmait déjà que la Science ne peut parler que du généralet reste impuissante à rien dire du singulier.

6. Si les Connaissances ne sont jamais convoquées qu'au pluriel dans cet article, c'est parce que ce pluriel est natif, autant que le singulier est exclu. Le propre des Connaissances étant d'être représentées de façon différentielle, elles ne peuvent l'être qu'en configuration moléculaire.

7. L'approche a en effet le mérite de proposer nativement des représentations et des dispositifs d'extraction/acquisition des Connaissances. Dans les faits, elle conduira d’ailleurs souvent des institutions (qui prendront la proposition de Newell au pied de la lettre et s'y conformeront avec un conformisme qui frisera parfois une taylorisation d'un genre nouveau et inédit) à prescrire leurs organisations et leurs savoirs (1982 n’arrive jamais que deux ans avant la funeste prévision de Georges Orwell).

8. Comme naguère Janus, les Connaissances ont deux faces, l’une tournée vers le Symbol Level des Machines, l’autre vers les actions humaines, toujours rationnelles et finalisées selon Newell.

9.

Qu'est-ce qu'un espace ? C’est un regard intentionnel sur un

ensemble, explicitant des dimensions d'espace, déterminant

une vue de l'ensemble dans ces dimensions, et manifestant le

renoncement à tout voir en dehors de ces dimensions. Si les

dimensions sont à la fois conditions de détermination

du vu et portées du voir, il est remarquable qu'elles ne sont

elles-mêmes ni vues ni données à voir, et un bon

espace est un espace qui donne à voir clairement parce qu'il

masque adroitement les ténèbres dans les dimensions.

Il en est par exemple ainsi pour l'espace-temps einsteinien, conçu

par le célèbre théoricien de la relativité

générale pour représenter clairement

l'obsédante question de la gravitation, et qui donne

satisfaction dans la mesure même où la gravitation se

trouve évacuée de l'espace de représentation

par encapsulation dans ses dimensions constituantes.

La

théorie de la relativité restreinte aborde le problème

des mouvements rectilignes et uniformes, en faisant abstraction

de l’accélération. Le problème de départ

est celui de la vitesse de la lumière, considérée

a priori comme invariante, et donc mettant en défaut le

principe d’additionnabilité des vitesses (cf. les fameux

trains dans lesquels on se promène avec une torche). La

solution à ce problème consiste à changer

d’espace et à prendre un espace à quatre dimensions,

incorporant le temps, et défini essentiellement par les

transformations de Lorenz. Dans ce nouvel espace, Einstein arrive à

réconcilier l’invariance de la vitesse de la lumière,

à l’aide d’une théorie cinétique ad hoc.

Mais ceci est réalisé au prix de deux escamotages :

premièrement la vitesse de la lumière, en un sens,

n’existe plus comme vitesse,puisqu’elle est

inatteignable par principe (les lois de cette mécanique font

converger toute vitesse vers celle de la lumière sans jamais

la dépasser). Deuxièmement, le temps est lui aussi

“pris au piège”, et figé dans une des dimensions.

On ne peut plus l'exprimer ”librement”, c'est-à-dire

indépendamment du reste de l’espace physique.

Accessoirement, la relativité restreinte cache aussi un